2024-11-02 01:31:52 3

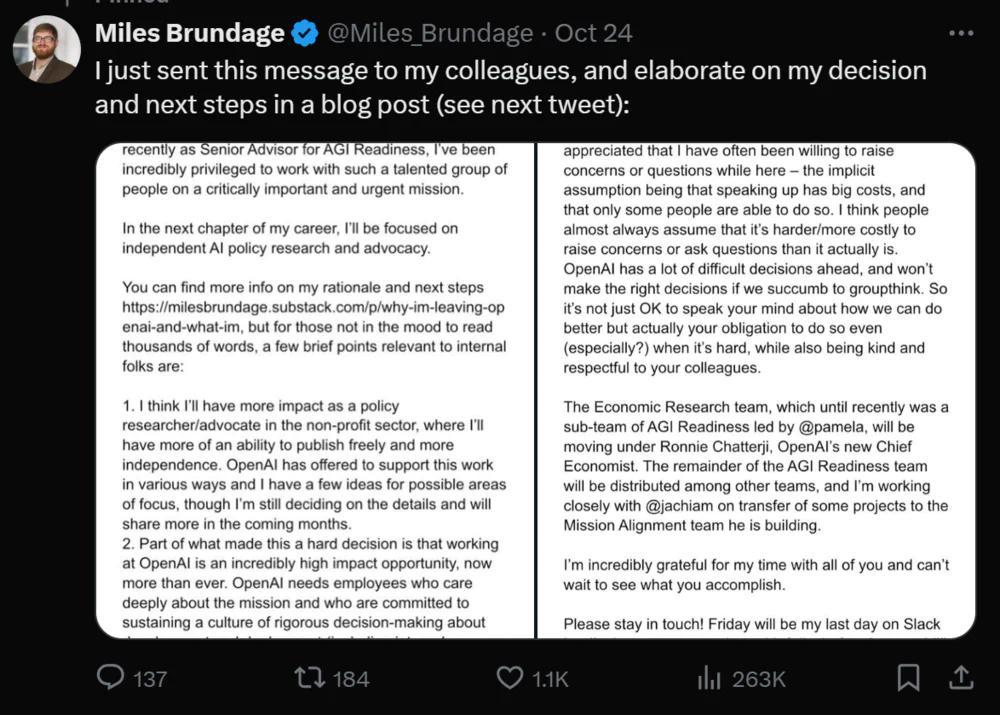

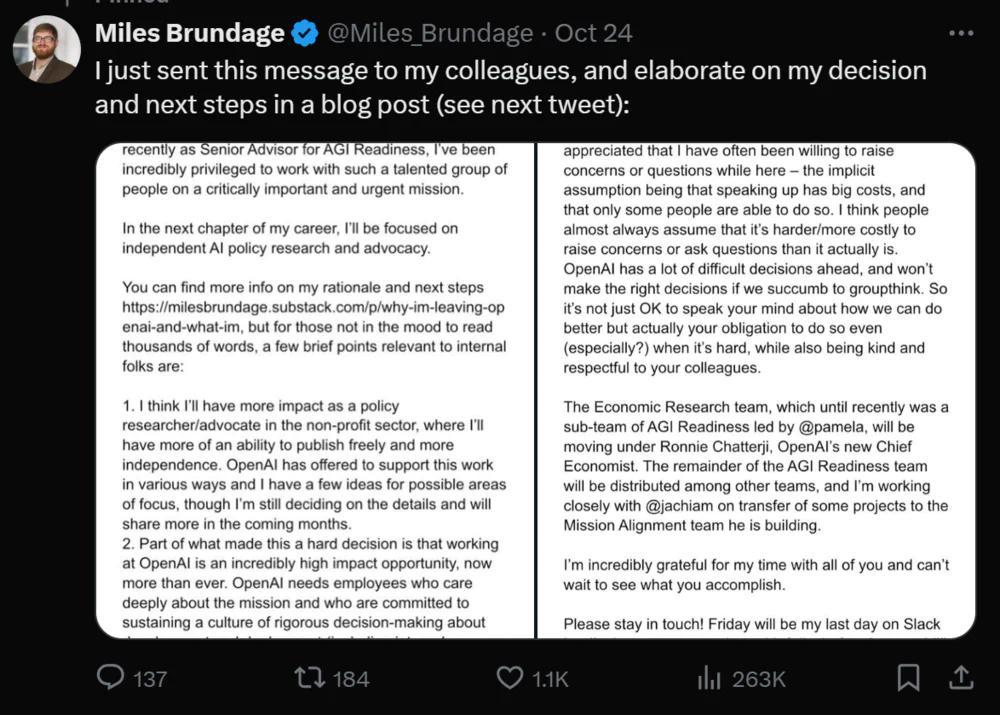

近日,OpenAI資深員工Miles Brundage宣佈從OpenAI離職,並稱專注於AI安全研究的“AGI Readiness”團隊將被解散,其餘成員將被分配於其他團隊。

作為“AGI Readiness”團隊的高階顧問,Miles Brundage離開OpenAI難免引起對AI安全的關注,他在 Substack的一篇帖子中表示,短時間內,在迎接通用人工智慧(AGI)方面,包括OpenAI在內的眾多人工智慧實驗室並未做好準備,世界也未做好準備。

為什麼從OpenAI離職,Miles Brundag表示自己更希望從外部影響人工智慧的發展。

Miles Brundag認為,自己留在OpenAI不得不面對更高的機會成本,這將不利於他從事更為重要的課題研究。儘管Miles Brundag認為人工智慧行業的發表限制具有合理性,但是過多的限制其實不利於自己對重要話題的發表與討論,而OpenAI則面臨著多方面的審查。

Miles Brundag希望可以減少偏見,而存在獨立於行業的聲音對此極為重要。他強調自己已經完成了大部分打算在OpenAI完成的事情,而關於世界對人工智慧的管理方面,他認為自己在外部會有更有效的貢獻。

針對人工智慧相關政策制定,Miles Brundag認為人工智慧造福全人類需要政府、非營利組織、民間社團和行業的決策者作出深思熟慮的選擇,這需要強有力的公共討論來提供資訊。

人工智慧有著極為明顯的優點,其缺點也同樣明顯。伴隨人工智慧的快速發展,政策制定者也需要快速採取行動。Miles Brundag對此表示興奮,他一方面認為符合公眾所需的人工智慧政策想法還未出現,一些觀點不好或者過於模糊,而另一方面他指出我們確實擁有一些被需要的想法亟待實施。一些意識或者政治意願處於缺失狀態,這是Miles Brundag不想將自己侷限於研究的一項原因。

Miles Brundag指出,數十家公司將在幾年時間內擁有足以造成災難性風險的系統,提高前沿人工智慧的安全性非常緊迫。

由於包括私人和社會利益的錯位等諸多原因,公司和政府不一定會在預設情況下給予人工智慧安全性應有的關注。Miles Brundag認為,監管可以減少私人和社會之間的利益錯位,對人工智慧技術的安全性做出把控。

在人工智慧的經濟影響方面,Miles Brundag表示,在未來幾年內,人工智慧可能會帶來足夠的經濟增長,如果有適當的政策來確保財富公平分配,人們能夠輕鬆實現提前退休。

人工智慧可能會在短期內破壞迫切需要工作的人的機會,Miles Brundag對此表示擔心,但他同時認為人類最終要消除以工作為生的義務,邁向“後工作世界”。

除了對前沿人工智慧安全性的監管以及經濟影響的關注,Miles Brundag還對人工智慧進展的評估預測、加速有益的人工智慧應用、計算治理以及整體“人工智慧大戰略”等多個課題表達了興趣。

關於離職後的計劃,Miles Brundag表示自己將成立新的非營利組織,或者加入現有的非營利組織,致力於人工智慧政策研究和倡導。

Miles Brundag表示自己的興趣是全球性的,但自己可能會更專注於自己更為熟悉的國家,如美國。

OpenAl為Miles Brundag提供了資金、API信貸和對新成果的早期模型訪問,並保證不會有與這種支援相關的出版前審查,但是出於對獨立性的考慮,Miles Brundag在文章中表示自己尚未決定是否接受這些提議。

2024-11-02 2 人在看

2024-11-02 2 人在看

2024-11-02 1 人在看

2024-10-31 2 人在看

2024-10-30 2 人在看

2024-10-29 4 人在看

2024-10-29 2 人在看

2024-10-27 2 人在看