2024-11-08 01:35:48 2

作者 | 陳駿達

編輯 | 漠影

AI時代,儲存不僅是資料的棲息之地,更是AI模型訓練、落地過程中的堅實底座。

在AI開啟的儲存行業新週期中,眾多廠商已將頻寬等效能指標卷至新的高度。然而,這種追求似乎將AI這一複雜應用場景簡單地“儲存化”了。

實際上,AI對儲存的需求遠不止於效能這一維度本身,更需要讓儲存“AI化”,關注整體儲存解決方案與AI應用場景的契合度。這一點,也是全球唯一的AI/ML儲存基準測試——MLPerf所關注的本質。

MLPerf儲存基準測試面向AI/ML使用者的痛點,即儲存和計算的平衡及兩者的有效利用。然而測試中儲存架構的多樣與存算節點的非標準化,導致效能資料本身的參考價值有所下降。

在效能資料之外,有無另一指標可以更為準確地反映儲存系統在AI場景的表現呢?MLPerf儲存基準測試要求加速器利用率需達到90%或70%,在這一區間內考核節點所能支援的最大加速卡數,測試其能否儘可能跑滿每個客戶端的理論頻寬,以實現最佳儲存效能。

在MLPerf儲存基準測試中,由於理論頻寬是統一的,因此所有廠商的解決方案均可歸一化到網路利用率這一指標上,進行相對客觀的評估。網路利用率的提高意味著成本的降低,算力潛能的更充分釋放,儲存與AI應用場景的契合度也越高。

今年9月,新一輪MLPerf儲存基準測試成績釋出,其中,中國企業浪潮資訊的分散式儲存平臺AS13000G7,在影象分割模型3D-UNet和天文學模型CosmoFlow共計8項測試中斬獲5項最佳成績。這一平臺在網路利用率上展現出20%左右的優勢,斷層領先。

值得一提的是,本次MLPerf儲存基準測試已升級至1.0版本,這一升級提出了哪些新的要求,浪潮資訊又是如何憑藉其技術積澱與整體解決方案,獲得新版測試中的多項最佳成績的呢?

一、MLPerf測試迎升級,儲存助力AI算天文分影象

2018年,圖靈獎得主大衛·帕特森(David Patterson)聯合斯坦福、哈佛等頂尖學術機構和谷歌、百度等AI行業頭部企業,共同發起了MLCommons協會,同年推出首款測試套件MLPerf,目前,該測試是影響力最廣的國際AI效能基準評測之一。

▲圖靈獎得主大衛·帕特森(圖源:ACM)

MLPerf系列測試套件得到學界和產業界的廣泛認可。其中,MLPerf儲存基準測試是專門用於AI複雜負載下儲存系統效能的測試套件,最大程度地模擬了AI任務的真實負載,資料訪問的pipeline、架構、軟體棧均與實際訓練程式無異,已成為AI/ML模型開發者選擇儲存解決方案的權威參考依據。

▲浪潮資訊是MLCommons的創始成員之一(圖源:MLCommons官網)

本次MLPerf儲存基準測試1.0版本測試吸引了全球13家領先儲存廠商和研究機構的參與,測試內容也迎來重大升級,回應了當下複雜AI應用場景對儲存提出的新需求。

一方面,儲存系統的頻寬峰值處理能力迎來新的挑戰,測試特別關注了在高效能GPU達到一定使用率的情況下,儲存系統能為AI叢集提供的整體頻寬和單個節點的頻寬。

另一方面,測試還強化了對分散式訓練的考察,特別關注每個儲存節點能夠支援的GPU數量,以此來衡量使用者在AI儲存方面的投資效益。

在本次測試中,浪潮資訊使用3臺AS13000G7平臺搭建分散式儲存叢集,並配備ICFS自研分散式檔案系統,參與了3D-UNet和CosmoFlow兩個單項的測試。

作為影象分割領域最具影響力的AI模型,3D-UNet模型的測試中使用了海量的影象類非結構化資料,要求儲存平臺具備高頻寬、低時延的特點,才能保證GPU的高效利用。CosmoFlow宇宙學分析模型引數量僅有10萬-20萬,如此之小的模型對時延提出了更高的要求。二者都是典型的資料密集型應用。

在3D-UNet多客戶端2評測任務中,浪潮資訊的儲存平臺服務於10個客戶端264個加速器,叢集聚合頻寬達到360GB/s,單個儲存節點的頻寬高達120GB/s。

在宇宙學分析CosmoFlow單客戶端2和多客戶端2評測任務中,浪潮資訊的儲存平臺分別提供了18 GB/s和52 GB/s的頻寬最佳成績。

二、契合AI使用場景,兼顧效能、效率、韌性

浪潮資訊多項最佳成績的背後,是其面向AI時代,提升儲存平臺效能、效率和韌性的努力。

效能層面,浪潮自研分散式軟體棧中的全新數控分離架構解決了分散式儲存資料流在節點間流轉的轉發問題,減少東西向(節點間)資料轉發量80%。這一效能的提升能幫助客戶節省大量的儲存成本,系統價效比也相應改善。

效率層面,浪潮資訊透過多協議資料融合技術,解決了AI應用場景使用多種資料接入協議造成的儲存效率問題,最高可節省50%的資料儲存空間。

韌性層面,為滿足AI業務對持續性的要求,浪潮資訊的可靠性主動管理技術、AIOps系統故障預測演算法和勒索軟體檢測技術,有效預防了裝置故障和資料安全問題的出現。相關技術對硬碟故障的預測準確率達到98%,對勒索軟體的檢測漏報率僅有0.029%。

如何將技術整合落地,將技術指標轉化為實際效果,最終形成完整且適配AI場景的解決方案,則是真正造福AI行業客戶的關鍵。

浪潮資訊與AI場景緊密契合,憑藉其產品場景化定製能力與成熟的AI場景解決方案能力,打造出了真正貼合AI需求的儲存產品,為AI場景構建堅實的資料支撐平臺。

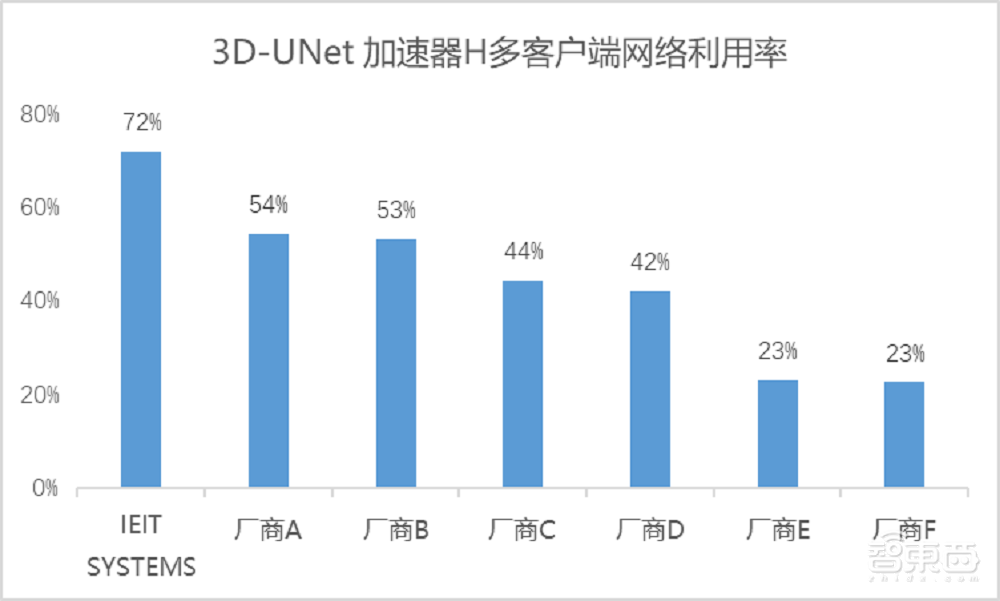

以本次測試中3D-UNet加速器H多客戶端下的測試結果為例,浪潮資訊的多路併發透傳技術有效減少了I/O操作中頻繁的上下文切換,降低單次I/O時延50%。本次測試的3D-UNet場景中,3節點儲存支撐了1430個高併發讀執行緒,計算節點網路利用率達到了72%。

網路利用率的提高有效降低了網路資源的浪費。在客戶端配置雙網絡卡情況下,部分參賽解決方案僅有50%的網路利用率,意味著整套方案實質上浪費了近乎一整張網絡卡資源,大大增加了總體成本。

若在大模型訓練的萬卡叢集下,低網路利用率造成的網絡卡資源的浪費可能高達數千萬級別,更不必說裝置擴容所引發的算力利用率下降、連線線增加、運維複雜度提升等連鎖成本效應。

對於本就成本高昂的AI基礎設施而言,任何可以削減的開支都顯得尤為關鍵。浪潮資訊儲存解決方案在網路利用率上的明顯優勢,證明了相關方案對AI場景的高度適配。

在實踐中,浪潮資訊的儲存解決方案已經在網際網路企業大模型訓練推理場景、大型AI算力中心與某國家重點實驗室中落地。

例如,在大模型場景訓練中,浪潮資訊透過增加全快閃記憶體儲幫助客戶實現效率提升,將斷電續訓時間降低到分鐘級別。新增20臺全快閃記憶體儲提升的效率,相當於新增了10多臺GPU伺服器,從投資角度上來看,每100萬儲存投資相當於300萬的GPU伺服器投資。

而針對大模型推理場景中多檔案協議特點,浪潮資訊的融合儲存方案讓客戶節省了協議轉化的時間,使得資料彙集準備時間節省30%,儲存空間也大幅節省。

結語:生成式AI步入下半場,儲存成AI向實關鍵

據工信部測算,到2035年,中國生成式AI的市場規模將突破30萬億元,製造業、醫療健康、電信行業和零售業對生成式AI技術的採用率迎來較快增長。

2024年,生成式AI正以前所未有的速度走入千行百業。AI行業已經由百模大戰時期的“卷模型”,轉變為“卷場景、卷應用”,或將迎來下半場的角逐。

在AI向實發展的程序中,資料是連線物理世界與數字世界的重要橋樑,而儲存作為資料的載體,持續在AI落地的實踐中發揮關鍵作用。

2024-11-16 0 人在看

2024-11-16 0 人在看

2024-11-16 0 人在看

2024-11-16 0 人在看

2024-11-16 0 人在看

2024-11-15 0 人在看

2024-11-15 0 人在看

2024-11-15 0 人在看