2024-11-01 01:35:11 5

原標題:全球最大AI超算內部首次曝光!馬斯克19天神速組裝10萬塊H100,未來規模還將擴大一倍

【新智元導讀】一文揭秘全球最大AI超算,解析液冷機架和網路系統的創新設計。這臺全球最大AI超算Colossus由xAI和英偉達聯手建造,耗資數十億,10萬塊H100僅半個多月搭建完成,未來規模還將擴大一倍!

兩個月前,馬斯克才剛剛自曝了xAI的Colossus超算,稱其是世界上最強大的AI訓練系統。

最近,馬斯克又宣佈了一條振奮人心的訊息——叢集即將擴充套件到20萬張H100/H200顯示卡!

同時,ServeTheHome也釋出了一條15分鐘的影片,公佈了這臺超算的詳情!

來自ServeTheHome的Patrick Kennedy帶著攝影機探訪了這臺超級計算機

這臺全球最大的AI超級計算機Colossus位於美國田納西州孟菲斯,配備了10萬個英偉達Hopper GPU,並由英偉達Spectrum-X乙太網提供網路傳輸支援。

目前,Colossus的第一階段建設已完成,叢集全面上線,但這並不是終點。它將很快迎來升級,GPU容量將翻倍,新增5萬塊H100 GPU和5萬塊下一代H200 GPU。

Colossus正在用於訓練xAI的Grok,併為X Premium訂閱使用者提供聊天機器人功能。

在訓練超大規模的Grok時,Colossus展現了前所未有的網路效能。在網路結構的所有層級中,系統在流量衝突的情況下沒有經歷任何應用延遲降級或資料包丟失。

透過Spectrum-X擁塞控制,它保持了95%的資料吞吐量。這種效能水平無法透過標準乙太網實現,標準乙太網在傳輸中會產生數千次流量衝突,資料吞吐量僅能達到60%。

由於保密協議的限制,這臺超級計算機的一些細節並沒有透露。不過,像Supermicro GPU伺服器等關鍵部件的介紹在影片中都有所涉及。

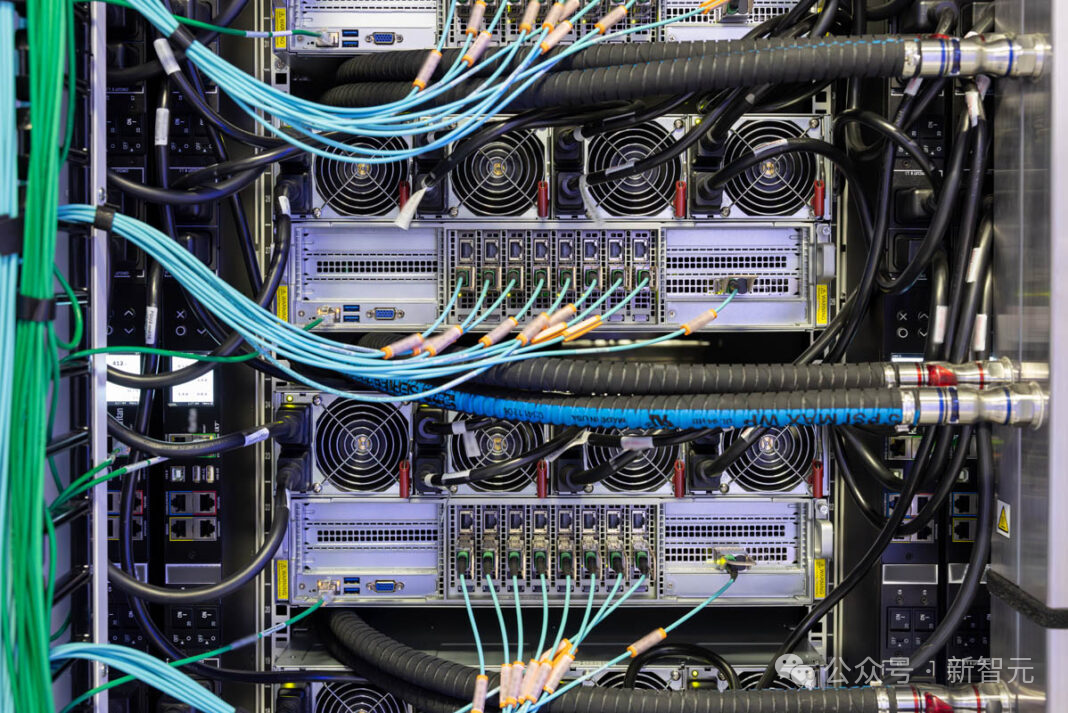

液冷機架

Colossus叢集的基本構建單元是Supermicro液冷機架。

每個機架包含八臺4U伺服器,每臺伺服器配備八個英偉達H100,共計64個GPU。

八臺此類GPU伺服器再加上一個Supermicro冷卻分配單元(CDU)及相關硬體,構成了一個GPU計算機架。

這些機架以八臺為一組排列,共512個GPU,並透過網路連線,形成更大系統中的小型叢集。

xAI使用的是Supermicro 4U通用GPU系統。

這是目前市面上最先進的AI伺服器,有2個原因:其一是它的液冷程度;其二是裝置的可維護性。

該系統被放置在托盤上,無需將系統從機架中移出即可維護。1U機架分流器可為每個系統引入冷卻液並排出溫熱液體。快速斷開裝置讓液冷系統可以迅速移除,甚至可以人工單手拆裝;移除後,托盤即可拉出以便維護。

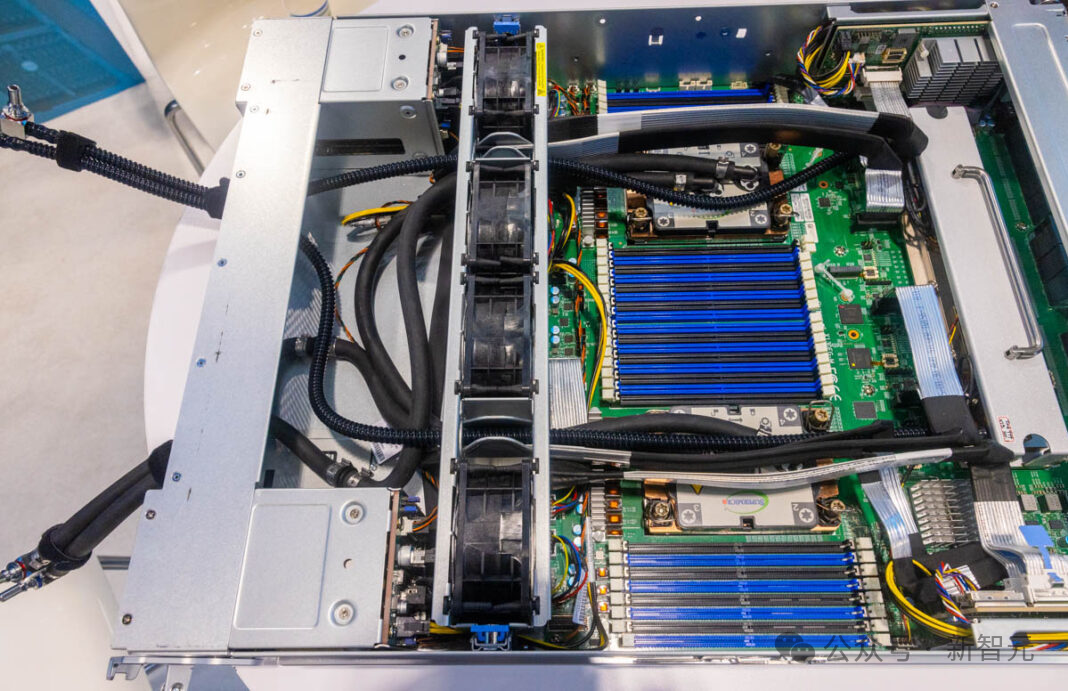

下圖是一張該伺服器原型的照片,展示了這些系統的內部構造。

SC23展示的Supermicro 4U通用GPU系統:支援液冷英偉達HGX H100和HGX 200

上圖SC23原型中的兩個x86 CPU液冷模組相對常見。

特別之處在於右側:Supermicro的主機板整合了幾乎所有HGX AI伺服器中使用的四個Broadcom PCIe交換機,而非將其單獨安裝在另一塊板上。Supermicro為這四個PCIe交換機設計了定製液冷模組。

其他AI伺服器通常是在風冷設計的基礎上加裝液冷,而Supermicro的設計則完全從零開始,為液冷而打造,且所有元件均來自同一供應商。

打個通俗的比方,這類似於汽車——有些車型先設計為燃油車,之後再安裝電動動力系統,而有些車型從一開始就是為電動車設計的。這款Supermicro系統就屬於後者,而其他HGX H100系統則屬於前者。

Patrick怒讚道:測評了各種各樣的液冷系統設計,這款Supermicro系統遙遙領先於其他系統!

網路系統

這裡的每條光纖連線速率為400GbE,是常見1GbE網路速率的400倍。此外,每個系統擁有9條這樣的連線,意味著每臺GPU計算伺服器的頻寬達到約3.6Tbps。

打個比方,如果1GbE的普通家庭網路好比是一條單車道公路,那這個400GbE就像是一條擁有400車道的高速公路。而每個系統有9條這樣的「高速公路」,相當於每臺GPU計算伺服器擁有9條這樣的超寬頻公路,總頻寬達到3.6Tbps。

這個頻寬甚至超過了2021年初頂級Intel Xeon伺服器處理器在所有PCIe通道上所能處理的連線總量。

GPU的RDMA網路構成了該頻寬的大部分。每個GPU都有自己的NIC。

在這裡,xAI使用英偉達BlueField-3 SuperNIC和Spectrum-X網路。英偉達的網路堆疊中加入了一些獨特技術,可以幫助資料繞過叢集中的瓶頸,確保資料準確地傳輸到指定位置。

這是一個重大突破!許多超級計算機網路使用的是InfiniBand或其他技術,而這裡採用的是乙太網。

乙太網是網際網路的骨幹,因此它具有極強的擴充套件性。這些龐大的AI叢集已擴充套件到一些更小眾技術未能觸及的規模。對於xAI團隊而言,這確實是一個大膽的舉措。

除了GPU的RDMA網路外,CPU也配備了400GbE連線,但使用完全不同的交換結構。xAI為其GPU和叢集的其餘部分分別配置了獨立的網路,這在高效能運算叢集中是非常常見的設計。

除了高速叢集網路外,還有低速網路用於管理介面和環境裝置,這些都是此類叢集的重要組成部分。

參考資料:

https://www.servethehome.com/inside-100000-nvidia-gpu-xai-colossus-cluster-supermicro-helped-build-for-elon-musk/3/

2024-11-03 2 人在看

2024-11-03 2 人在看

2024-11-02 3 人在看

2024-11-02 2 人在看

2024-11-01 1 人在看

2024-11-01 1 人在看

2024-10-31 1 人在看

2024-10-30 2 人在看