2024-08-31 14:39:15 55

上世紀末的作品《攻殼機動隊》中,全身義體化的素子,懷疑自己是否仍然存在。身體、記憶和其他人的關係,當這些事物都能夠被複制,也就無法成為肉身生命的論據。

AI 歌手爆火之時,孫燕姿也在回應裡提出類似的觀點,你並不特別,你已經是可預測的,而且不幸你也是可定製的。

我們可以加上一句,任何人都是可以被 AI 描述和生成的,哪怕你從未做過某些事情。

魯迅真的說過,一見短袖子,立刻想到白臂膊。人類的想象力是共通的,毫不意外,每當技術有新進展,某個垂直賽道會被開發得越發成熟:搞黃色。

曾經因為 N 號房震驚世界的韓國,此時此刻正在上演 2.0 版本。

普通人對普通人的暴力

之前的 N 號房事件,作案人在加密即時通訊軟體 Telegram 上建立多個聊天室,釋出性剝削內容。這次的事件,也主要發生在 Telegram。

兩者主要是犯罪手段的區別:一個是偷拍,一個是 Deepfake(深度偽造)。

我們早已對 Deepfake 不陌生,它利用 AI 生成看似真實的影片、音訊或影象,模擬實際沒有發生的事情。

Deepfake 常用在娛樂圈和政治人物,但它也正被普通人所掌控,拿來傷害其他普通人。

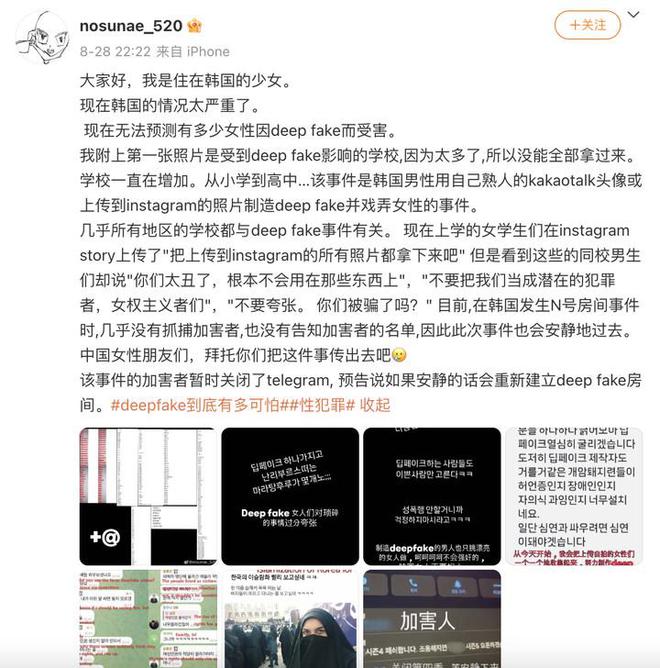

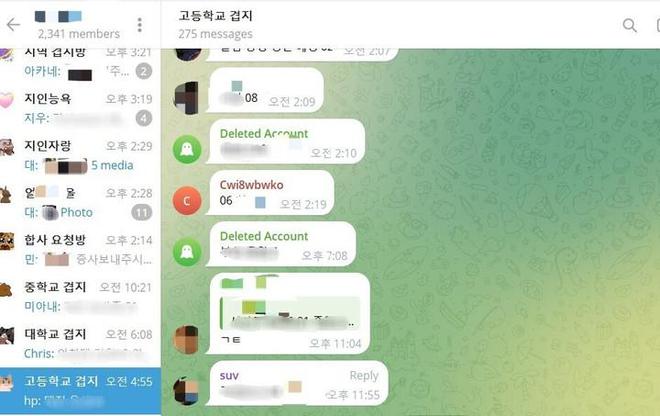

N 號房 2.0 的加害人們,將魔爪伸向了身邊的家人、同事和同學,很多 Telegram 聊天室按照學校或者地區組織,所以群友有共同的熟人、臭味相投的話題。

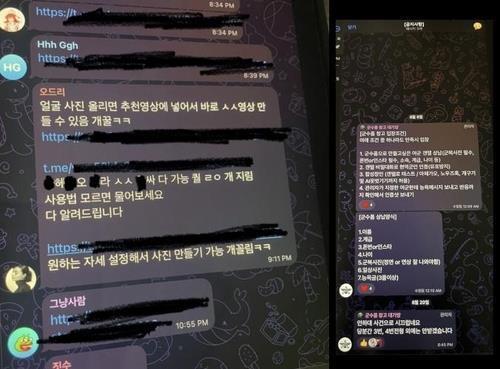

▲ 按高校區分的聊天室

除了身邊女性,女明星也是他們圍獵的物件。有些聊天室甚至細分到了職業型別,包括教師、護士、軍人等。

《韓民族日報》報道,一個 22.7 萬人參與的 Telegram 聊天室,只需要女性的照片,就能在 5 到 7 秒內生成 Deepfake 內容。

22 萬什麼概念?韓國 2023 年新生兒人數只有 23 萬,總人口數只有 5000 多萬。

這個聊天室內建一個將女性照片合成為裸照、並能調整胸部的機器人,使用者進入聊天室後,聊天視窗會立即彈出訊息:「現在傳送你喜歡的女性照片。」

▲ 聊天室截圖,說明 Deepfake 的使用方法

參與者數量多到令人髮指,或許和「准入門檻」不高有關:在 X(原 Twitter)透過搜尋特定關鍵詞就可以找到連結。

這個聊天室還建立了變現模式。前兩張照片免費,之後收費,每張照片收費 1 鑽石(0.49 美元,約 3.47 人民幣)。支付只能用虛擬貨幣,以便匿名。如果邀請朋友,也可以拿到一些免費額度。

但也有些聊天室需要「投名狀」——想進群,先提交 10 張認識的人的照片,並透過面試。

聊天軟體 KakaoTalk 的頭像、Instagram 的照片,都可以作為「原材料」。

更細思極恐的是,受害者和加害者裡,青少年的比例都不小。

志願者們做了實時更新的地圖,顯示犯罪發生在哪些學校。就算是女子學校也會有受害者,因為加害者不一定是同學。

到底有多少學校受到影響,目前還沒有定論。有博主稱,這次涉及了超過 70% 的學校。

8 月 26 日,《韓國中央日報》指出,至少包括全國約 300 所的學校,其中甚至還有小學。8 月 28 日,WSJ 的報道又將數字擴大到了約 500 所。

一位網友在評論區感嘆:「這基本上就是整個韓國了……」

雖然此次事件還沒有明確的調查結果,但過去的資料也能說明情況的嚴重性。

韓國婦女人權研究所統計,從今年 1 月到 8 月,共有 781 名 Deepfake 受害者尋求幫助,其中有 288 名未成年人,佔比 36.9%。真實數字可能遠高於此。

另外,韓國國家警察廳稱,自 2023 年初,約 300 名被指控制作和分發虛假裸照的人中,約 70% 是青少年。

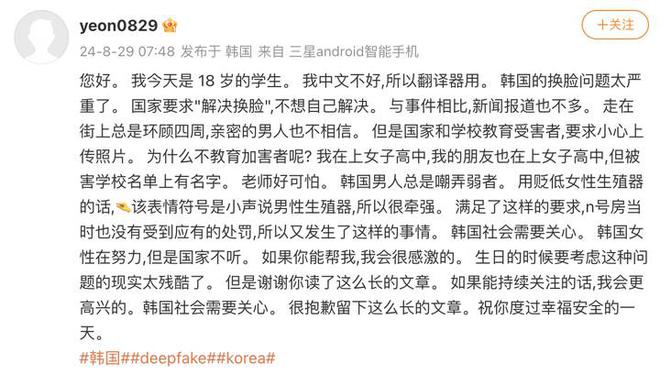

不少韓國女性到微博發出求助,她們不會中文,只能機翻內容,傳遞無助和恐懼,「N 號房 2.0」一度衝上微博熱搜。

有些網友奇怪為什麼韓國女性跑到中文網際網路求助,其實不只是中文,韓國女性也有用其他語言發聲,除了韓國內部,新加坡、土耳其等國的媒體也報道了這起事件。

她們認為,被外國人關注和批評的話,媒體會更積極地報道,相關部門會更認真地調查,而不是裝聾作啞和息事寧人。

一些犯罪證據乃至始作俑者的身份,是韓國女性自己調查的,類似當年的 N 號房。好在,韓國總統和在野黨領袖已經表態了,韓國總統尹錫悅提出:

Deepfake 是一種明確的數字性犯罪,我們將徹底根除它們。 Deepfake 可能被看作是惡作劇,但它顯然是在匿名掩護下利用技術的犯罪行為,任何人都可能成為受害者。

Telegram 的伺服器在海外,其執行長又被拘留在巴黎,所以調查起來有困難。韓國通訊標準委員會表示已經致函,要求法國政府配合調查 Telegram。

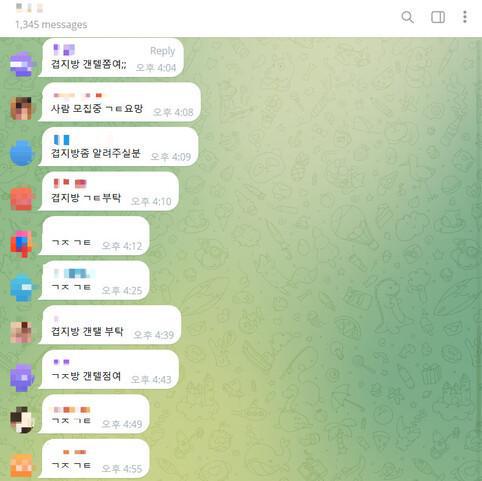

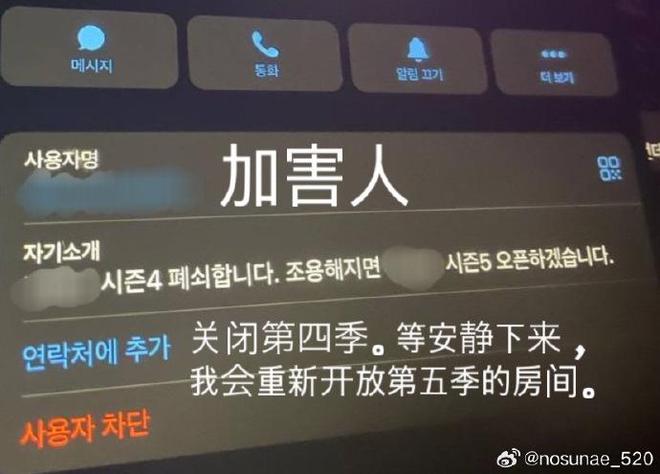

被輿論關注之後,相關行為有所收斂,但《韓民族日報》又跟蹤報道發現,有些賊心不死的使用者,會透過更嚴格的「身份驗證」,在更私密的聊天室繼續 Deepfake。

▲聊天室截圖,使用者討論加入更私密的聊天室

虛假的內容,真實的傷害

Deepfake 不是新鮮事,但它的傷害其實很少被正視。

韓國一些女性將自己的社交賬號設為私密,或者刪除釋出在網上的照片,嘗試做些補救。

她們既痛苦,又懷疑。一方面,她們不知道,自己的照片被分享到了哪,傳播了多遠。另一方面,她們不理解,為什麼都在要求受害者小心上傳照片,而不是教育加害者。

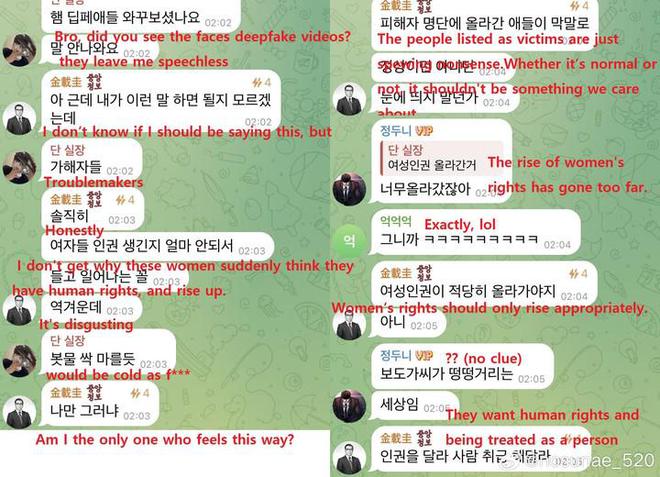

當女學生在 Instagram 的 Story(快拍)呼籲「把上傳的所有照片都拿下來吧」,同校男生們卻能說出「你們太醜了,根本不會用在那些東西上」這種荒謬言論。

▲加害者的言論,說女性站得太高了

網上還不乏這樣的聲音:「不知道這種犯罪為什麼會造成很大的傷害。」「如果是幾個人自己製作的,傷害應該很小吧。」

但受害者們所經歷的,不僅是看到自己的臉被 Deepfake。加害者們還會侮辱她們,散佈她們的地址、電話、學生證等個人資訊,造謠她們的私生活,接近並騷擾她們。

更可怕的是遇上「復仇色情」——加害者以傳播 Deepfake 材料為威脅,勒索和傷害女性,造成更嚴重的二次傷害。

▲一個韓國 YouTuber 說女性大驚小怪,但他知道蒙面保護自己

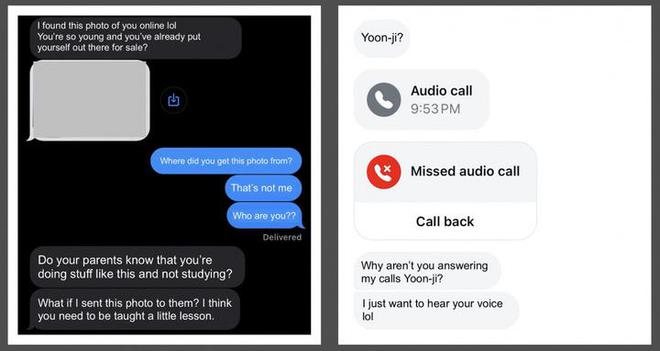

《韓國先驅報》報道,17 歲的京畿道高中生 Song,以前經常在網上分享一些跳舞的照片和短影片。一天,她在 Instagram 收到了一條附有三張露骨照片的匿名訊息:「你的朋友和父母瞭解你生活的這一面嗎?」

這些照片都是 Deepfake 的,但幾乎沒法和真實影象區分。噩夢沒有結束,她回覆的訊息,只會讓對方更興奮、提出更多的要求。

▲Song 和加害者的簡訊截圖,根據 Song 的要求進行了修改並翻譯成英文

沒有誰能分擔痛苦。甚至有受害者表示:「我所知道的世界已經崩塌了。」

這和加害者為此付出的代價不對等。

▲聊天室截圖,一些猥瑣發言,如「可以設定你想要的姿勢來製作照片,超爽」

此次事件尚未塵埃落定,但韓國之前有對 Deepfake 判決,其中一起在 8 月 28 日進行了一審。

從 2020 年 7 月到今年 4 月,樸某盜用大學校友等女性受害者的臉部照片,製作了 419 個 Deepfake 色情影片,並傳播了 1735 個,被判處有期徒刑 5 年。

受害者們從 2021 年 7 月開始輾轉奔走,才成功將加害者推上審判臺,讓樸某在今年 5 月被起訴。

因為這次大型 Deepfake 事件,韓國相關部門考慮,將最高刑期從 5 年提高到 7 年。

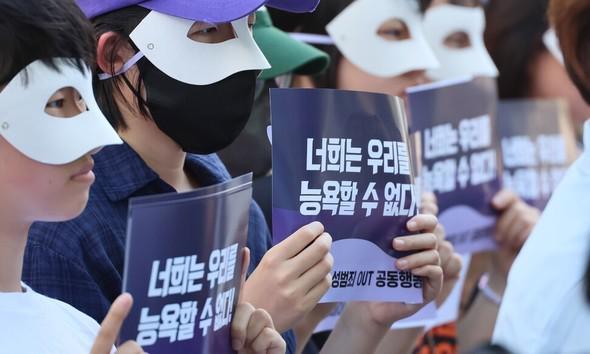

▲韓國女性發聲,抗議性犯罪

又考慮到 Deepfake 的青少年犯罪很常見,但法律有漏洞,韓國正在衡量義務教育階段作案人的最高懲罰。

時至今日,Deepfake 在很多地方仍是灰色地帶,保護力度跟不上威脅速度。

比如在美國,如果受害者是成年人,各州有不同的法律規定,或定為刑事犯罪,或提起民事訴訟,但目前還沒有聯邦層面的法律禁止製作 Deepfake 色情內容。

▲聊天室截圖,成員聊共同的熟人

之所以立法困難,一個原因在於,有些觀點認為,Deepfake 圖片裡的主體就算長得像你,實際並不是你,所以你的隱私並沒有真正受到侵犯。

然而誰都清楚,圖片雖然虛假,傷害是真實存在的。

法律推進緩慢,與此同時,那些未曾露面的加害者,暫時「偃旗息鼓」,等待「捲土重來」。

作惡如此簡單,Deepfake 和所有人有關

韓國並非個例,Deepfake 的發生不限國界。

2023 年 9 月,西班牙的小鎮阿爾門德拉萊霍,一群男生將女同學發在社交媒體的照片上傳到了一款「一鍵脫衣」AI 工具。小鎮有五所中學,女同學的「裸照」在至少四所流傳。

這款工具可以透過手機 app 或者 Telegram 使用,受害者至少有 30 名,主要是 12 歲到 14 歲的女學生。

始作俑者大多和她們認識,也是未成年人,至少有 10 名,部分甚至未滿 14 歲,不能面臨刑事指控。

▲一位母親呼籲更多受害者站出來

他們在 WhatsApp 和 Telegram 建立群聊傳播這些「裸照」,透過 Instagram 威脅受害者,勒索「贖金」和真人裸照。

美國新澤西州的一所高中發生過類似的情況,受害者也在 30 名左右,她們的男性同學在暑假製作了「裸照」。

校長保證,所有圖片已被刪除,不會再被傳播,始作俑者被停學了幾天,又像沒事人一樣回到「案發地點」。

Deepfake 最早興起於 2017 年的「美版貼吧」Reddit,主要形式是將明星的臉替換到色情影片的主角身上,或者惡搞政界人物。

從技術原理來說,主要有兩條路徑:一是編碼器-解碼器路徑,透過將影象進行壓縮和重建,將一張臉替換成另一張臉;二是生成器-鑑別器路徑(即生成對抗網路,GAN),透過對抗訓練生成逼真的影象。

▲GAN

如今,Deepfake 是一個更為廣義的概念,不再僅限於最初的面部替換,我們用它來指代透過技術手段偽造現實的一切行為。

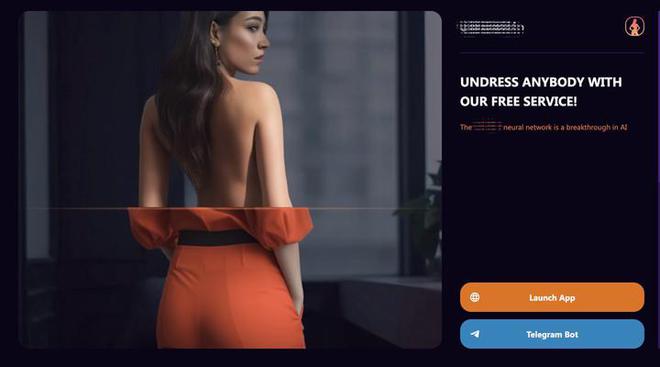

複雜的技術原理隱藏幕後,在使用者面前的是一個個「開箱即用」的介面,青少年們也能隨手製造虛假資訊,Deepfake 從一門技術,墮落為幾乎沒有門檻的工具。

「一鍵脫衣」的 app 們,只需要一張照片、一個電子郵件地址和幾美元,就可以批次脫掉名人、同學、陌生人的「衣服」,被用來「脫衣」的圖片,往往從社交媒體獲取,未經發布者同意,然後也在他們不知情的情況下傳播。

基於接受過海量圖片訓練的開源擴散模型,使用者可以透過輸入提示詞的方式,生成名人的虛假露骨照片。

▲好萊塢女星的 AI 模型,已經下載上千次

像 Deep-Live-Cam 這樣的開源 GitHub 專案,透過一張照片,就能在影片聊天中換臉。

騙過年輕人或許有難度,但是長輩們就不一定了,現實的慘痛例子已經上演——美國的一位 82 歲老人,因為盲信在影片裡坑蒙拐騙的 AI 馬斯克,損失了 69 萬美元的退休金。

▲ AI 馬斯克的直播

2023 年 7 月,德國電信發了一條關於兒童資料安全的廣告,呼籲家長儘量少在網際網路分享兒童隱私。

影象、影片和音訊,都在被 Deepfake,雖然理智明白「眼見為實」成了過去時,但我們的心理還沒有完全接受,也不具備對應的分辨能力,所有人都可能成為受害者。

技術或許中立,但人用技術產出的資訊不只是資訊,也是用來進行羞辱、汙名和獲得優越感的武器。越低俗和獵奇的內容,越容易傳播,自古皆然。

普通人可以做些什麼?至少我們可以決定自己如何使用技術,也可以選擇產出和傳播什麼資訊,對受害者給予關注,對加害者嗤之以鼻,以微末的力量,推動法律和社會觀念的進步。

被換臉,為什麼是受害者刪除照片?被偷拍,為什麼是受害者深感羞恥?這似乎是技術也沒法回答的問題。

2024-08-30 5 人在看

2024-10-13 0 人在看

2024-10-13 0 人在看

2024-10-13 0 人在看

2024-10-11 0 人在看

2024-10-11 0 人在看

2024-08-31 1 人在看

2024-08-31 1 人在看